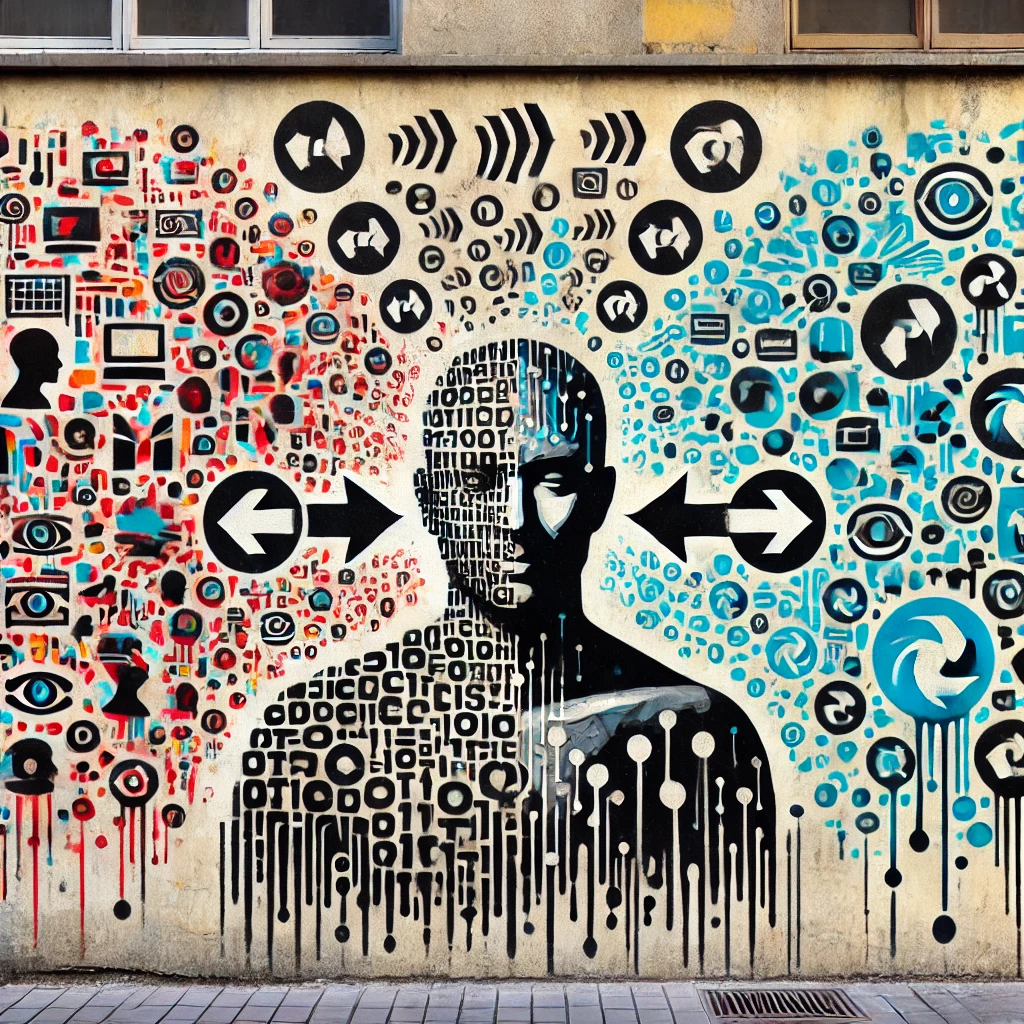

Il ruolo dei token nei modelli di intelligenza artificiale

I token sono unità di dati fondamentali per l’intelligenza artificiale, utilizzate per l’addestramento e l’inferenza dei modelli. La loro efficienza influisce direttamente sulle prestazioni e sui costi computazionali.

Come funziona la tokenizzazione nell’AI

La tokenizzazione suddivide dati testuali, visivi o audio in unità più piccole. Ad esempio, nei modelli linguistici, parole lunghe vengono spezzate in più token, facilitando l’apprendimento delle relazioni semantiche. Nei modelli visivi, invece, le immagini vengono trasformate in token discreti per l’elaborazione.

Token e economia dell’intelligenza artificiale

Il valore dell’intelligenza artificiale è misurato in token: più un modello elabora token, più informazioni genera. Le fabbriche AI ottimizzano il costo per token, rendendo più accessibile l’uso dei modelli avanzati. Le aziende offrono piani tariffari basati sul consumo di token, rendendoli una risorsa economica strategica.

Fonti:

- NVIDIA Blog: https://blogs.nvidia.com

- OpenAI Research: https://openai.com/research

- MIT Technology Review: https://www.technologyreview.com