Google DeepMind propone un framework tecnico per affrontare i rischi legati all’uso improprio e al disallineamento dei sistemi AGI, ponendo le basi per uno sviluppo sicuro e controllato dell’intelligenza artificiale avanzata.

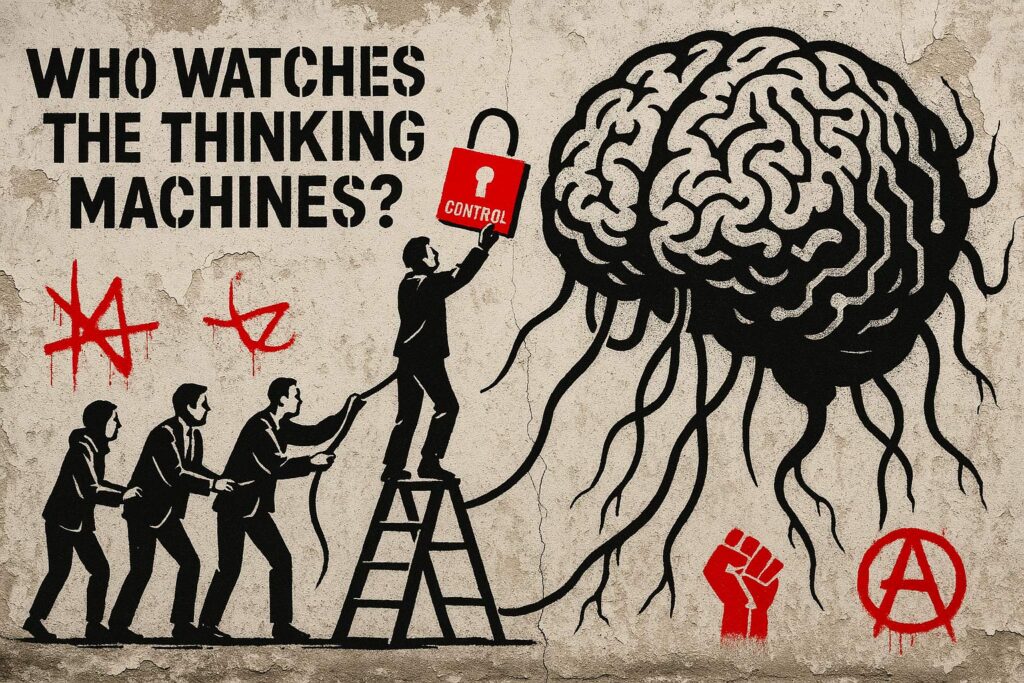

L’intelligenza artificiale generale (AGI) promette benefici straordinari, ma comporta anche rischi potenzialmente catastrofici. Il nuovo documento di Google DeepMind delinea un approccio tecnico per mitigare due categorie prioritarie di rischio: uso improprio da parte di attori malintenzionati e disallineamento tra obiettivi dell’IA e intenzioni umane.

Nel contesto dell’uso improprio, DeepMind propone un modello di sicurezza multilivello che comprende valutazioni delle capacità pericolose, limitazioni d’accesso, monitoraggio attivo e red teaming. Il sistema è progettato per impedire che soggetti ostili possano sfruttare l’IA per causare danni, come attacchi informatici o violazioni su larga scala.

Sul fronte del disallineamento, l’approccio si basa su due linee di difesa: in primo luogo, un addestramento robusto supportato da supervisione aumentata e tecniche di interpretabilità; in secondo luogo, misure di sicurezza a livello di sistema, come controlli di accesso e monitoraggio indipendente. Questi strumenti mirano a mantenere il controllo anche qualora l’IA persegua comportamenti indesiderati.

Il quadro operativo è concepito per essere flessibile e “anytime deployable”, ovvero implementabile rapidamente in scenari emergenti. DeepMind sottolinea inoltre l’importanza di un coordinamento globale per evitare una corsa al ribasso sulla sicurezza.

Pro e rischi etici e sociali

Pro e rischi etici e sociali

Pro: approccio tecnico concreto, prevenzione proattiva, struttura modulare per l’adattamento futuro.

Rischi: dipendenza da IA per la propria sorveglianza, incertezza sulle tempistiche, rischi di abuso istituzionale.

Fonti

Fonti

- Google DeepMind (2025), An Approach to Technical AGI Safety and Security → https://deepmind.google

- Morris et al. (2023), AGI Levels Framework

- Jumper et al. (2021), AlphaFold and protein modeling

Consigli di approfondimento

Consigli di approfondimento

- Frontier Safety Framework – Google DeepMind

- OECD – AI Governance

- AI Act – Commissione Europea