Un nuovo studio rivela come identificare i dati memorizzati da modelli linguistici proprietari come GPT-4, senza accesso interno.

Un team di ricercatori ha sviluppato un metodo innovativo per identificare i dati di training all’interno dei modelli linguistici di grandi dimensioni (LLM) proprietari, come GPT-4, senza accedere ai pesi del modello né alle probabilità dei token. Il metodo si basa su “sonde guidate dalle informazioni”, che sfruttano passaggi di testo ad alta sorpresa per verificare la presenza di contenuti memorizzati.

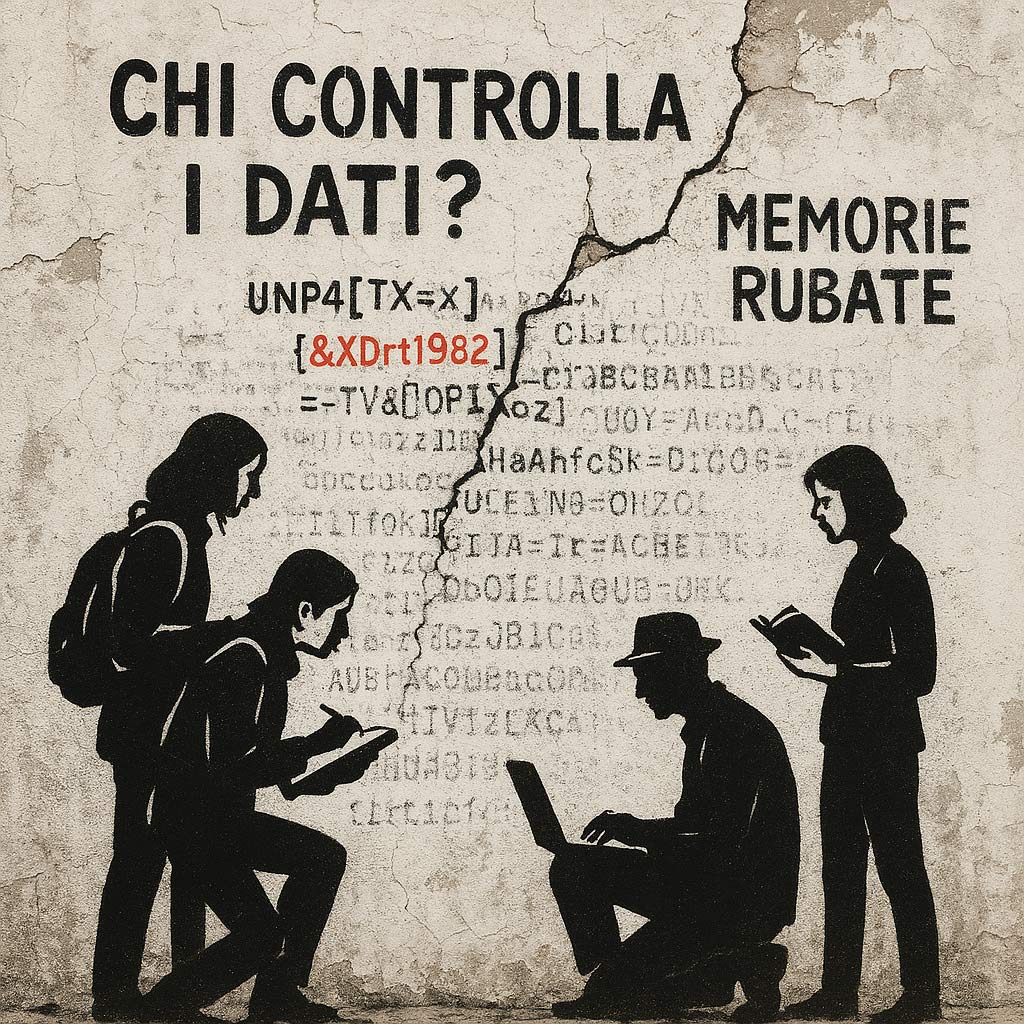

La trasparenza sui dati di addestramento è limitata nei modelli commerciali, rendendo difficile verificare la presenza di contenuti protetti da copyright, dati sensibili o manipolazioni. Questo lavoro rappresenta un passo avanti verso una maggiore accountability, offrendo uno strumento efficace per verificare quali informazioni siano note al modello.

La chiave dell’approccio risiede nell’identificare token rari o inaspettati (ad alta sorpresa) e osservare la capacità del modello di ricostruirli. Se il modello riesce a completare coerentemente un passaggio complesso o inusuale, ciò suggerisce un’alta probabilità che lo abbia incontrato nei dati di training. L’esperimento ha rivelato una significativa quantità di testi effettivamente memorizzati da GPT-4, dimostrando come gli LLM non solo apprendano, ma immagazzinino porzioni di testo specifiche.

Questo metodo rafforza il dibattito sulla necessità di trasparenza e supervisione dei modelli proprietari, soprattutto in ambiti dove sono coinvolti diritti d’autore, privacy e impatti sociali.

Fonti:

- Allen Institute for AI – Link allo studio

- AI Ethics Guidelines, European Commission – Link

Approfondimenti consigliati:

- Come i LLM apprendono: guida alla memorizzazione nei modelli AI

- AI e copyright: le nuove sfide legali

Conclusioni – Pro e rischi

✅ Pro: migliora la trasparenza e la responsabilità dei modelli; utile per la ricerca scientifica.

⚠️ Rischi: possibile esposizione involontaria di dati sensibili; impatti etici sul copyright e sulla privacy.