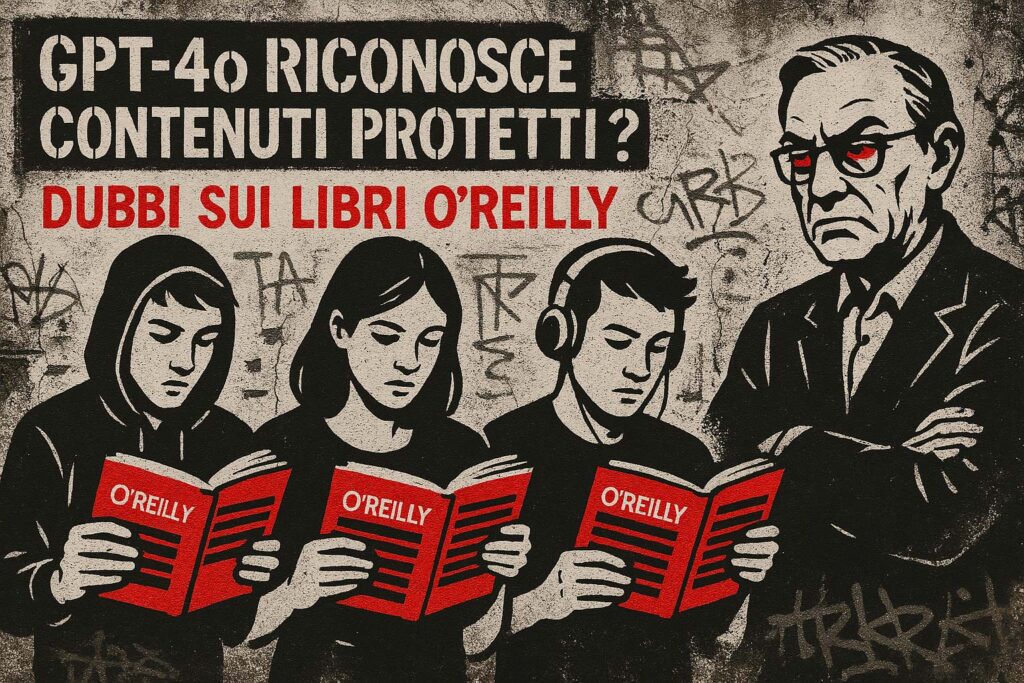

Una ricerca indipendente rivela il possibile utilizzo di contenuti non pubblici da parte di OpenAI. Serve trasparenza nei dati di addestramento.

Uno studio dell’AI Disclosures Project (Social Science Research Council), guidato da Sruly Rosenblat, Tim O’Reilly e Ilan Strauss, ha messo sotto esame i dataset usati per addestrare i modelli linguistici di OpenAI. Usando il metodo DE-COP, un test di membership inference, gli autori hanno analizzato 34 libri protetti da copyright pubblicati da O’Reilly Media, confrontando i risultati su diversi modelli di OpenAI.

La ricerca ha rilevato che GPT-4o, il modello più avanzato dell’azienda, mostra una forte capacità di riconoscere contenuti non pubblici (AUROC 82%), suggerendo un possibile utilizzo di dati riservati nel pre-training. In confronto, GPT-3.5 Turbo ha mostrato maggiore familiarità con versioni accessibili pubblicamente degli stessi testi. Il modello GPT-4o Mini, invece, non ha riconosciuto né contenuti pubblici né protetti (AUROC ≈ 50%), rafforzando la tesi che le performance derivino dalla quantità e tipologia dei dati usati.

Questi risultati sollevano interrogativi sull’etica e la legalità dell’addestramento dei LLM con dati protetti da copyright senza consenso. Gli autori chiedono maggiore trasparenza aziendale e accordi di licenza formali per l’utilizzo dei contenuti nel training dei modelli.

📚 Fonti

- AI Disclosures Project (SSRC): ssrc.org

- Institute for Innovation and Public Purpose, UCL: ucl.ac.uk/iipp

- O’Reilly Media: oreilly.com

🔍 Approfondimenti

⚖️ Conclusioni

Pro

- Aumento della consapevolezza pubblica sul tema del copyright

- Spinta verso modelli di licensing più equi

Rischi etici e sociali

- Violazioni sistemiche del diritto d’autore

- Rischio legale per le aziende tech

- Erosione della fiducia in tecnologie AI “black box”